Les dernières

ACTUALITÉS

2024 Acquisition applications CI/CD CLOUD Communiqué de presse continuous delivery continuous deployment cycle de développement logiciel Data Data Analyse Data Architecture data fabric Data Gouvernance data management data observability Data visualisation DevOps Devsecops Digital déploiement déploiement continu ERP ERP Oracle ESG IA IA générative intelligence artificielle intelligence artificielle générative intégration continue Livre Blanc LLM machine learning Migration Oracle Cloud plateforme d'ingénierie Responsabilité numérique SDLC Smart Implementation tendances digitales Tendances tech 2024 Usine logicielle

-

MACHINE LEARNING VS DEEP LEARNING : quelles différences ?

L’intelligence artificielle (IA) redéfinit les capacités des machines, permettant des avancées technologiques qui transforment nos interactions avec le monde numérique. Parmi ces technologies, le Machine Learning et le Deep Learning jouent un rôle crucial en améliorant le traitement des données et en ouvrant la voie à des innovations dans divers secteurs.

-

3 tendances digitales en 2024 : IA gén, Apps intelligentes…

Dans cet article, nous explorons trois tendances digitales clés de l’année 2024 : l’intelligence artificielle générative, l’ingénierie de plateforme et les applications intelligentes. Ces tendances émergent comme des moteurs majeurs de transformation dans le paysage technologique actuel, offrant des opportunités significatives pour les entreprises de toutes tailles et industries.

-

Migration ERP oracle vers le cloud – les bonnes pratiques

D’ici 2025, 85% des entreprises adopteront le Cloud First (source : Gartner). Votre ERP est-il prêt pour le grand saut ? Rejoignez les leaders du secteur qui profitent déjà d’une agilité sans précédent, d’une efficacité redoutable, et d’une innovation continue grâce à la migration vers le cloud.

-

intelligence artificielle : définition, types et domaines

Découvrez l’évolution et l’impact de l’intelligence artificielle, de ses débuts en 1956 à son influence actuelle, ainsi que ses différentes branches et applications. Explorez comment l’IA façonne notre monde moderne et ses implications dans divers domaines, de la santé à la finance en passant par les entreprises.

-

Data Analyst et data scientist : comparaisons et Similitudes

Qui fait quoi entre le Data Analyst et le Data Scientist? Vous vous êtes certainement déjà posé cette question. En effet, ces deux postes peuvent porter à confusion. Nous explorerons en détail les différences et les similitudes entre ces deux rôles clés.

-

Téléchargez notre livre blanc sur l’IA Générative

Explorez l’avenir de l’intelligence artificielle générative avec notre livre blanc exclusif sur l’intégration de l’IA générative dans le développement logiciel. Découvrez des stratégies novatrices, des études de cas pertinents et des conseils pratiques pour optimiser votre processus de développement, tout en exploitant les capacités créatives de l’IA. Téléchargez dès maintenant notre livre blanc pour rester…

-

Qualité des données : outils et tendances en 2024

En 2024, la qualité des données répond à une forte demande. Cet article explore les outils innovants et les tendances émergentes qui redéfinissent l’écosystème de la gestion des données.

-

Data hub vs data lake

Les termes « Data Hub » et « Data Lake » sont courants dans le domaine de la gestion des données. Bien que ces deux concepts peuvent sembler similaires à première vue, ils sont différents. Nous vous décortiquons ces deux termes.

-

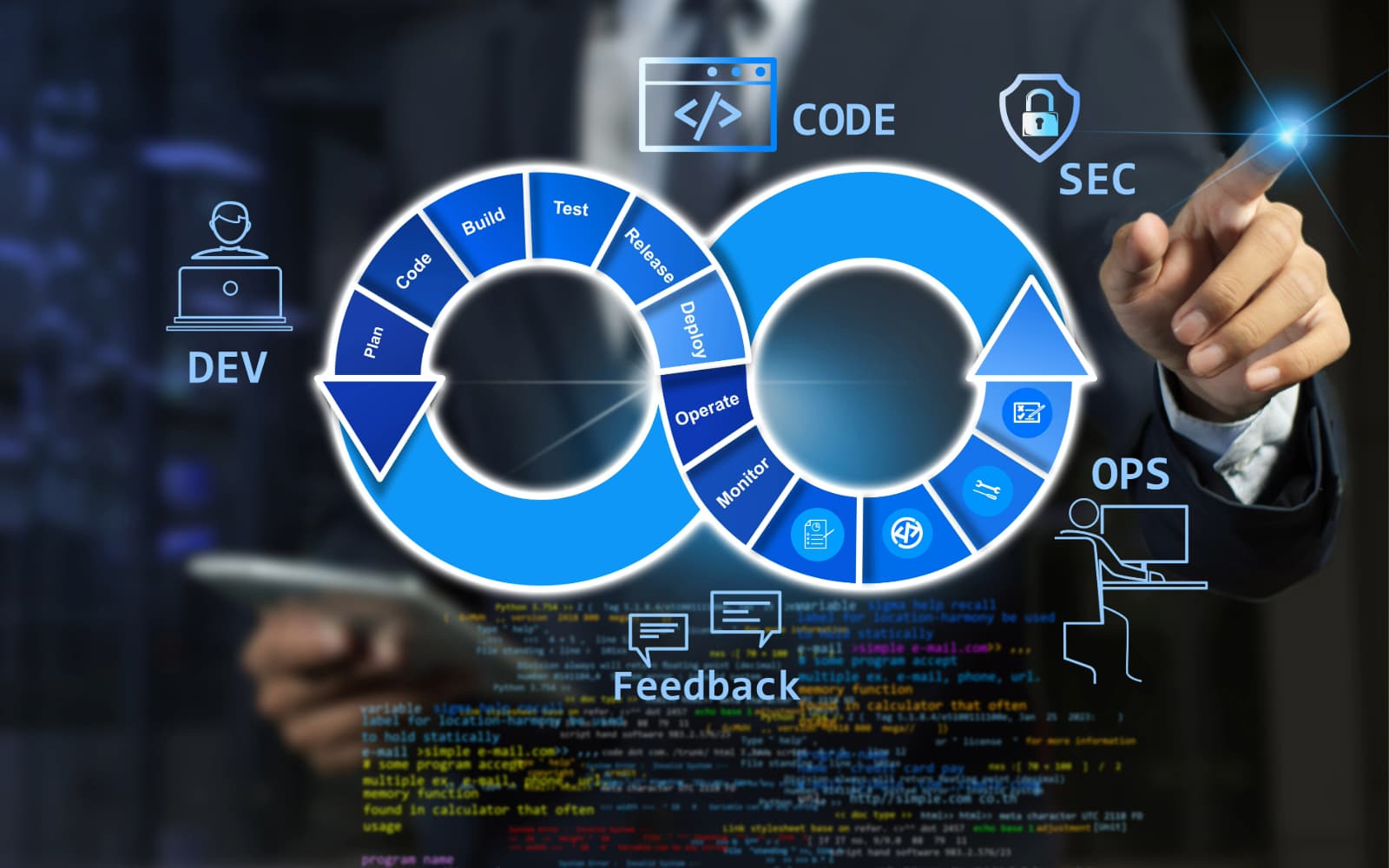

Déploiement continu : son importance dans la pipeline CI/CD

Le déploiement continu (CD), au cœur de DevOps et DevSecOps, automatise le déploiement et les mises à jour logicielles pour des cycles de développement plus rapides. Les tests jouent un rôle clé, permettant la détection précoce des erreurs pour des corrections rapides. Cette pratique garantit des déploiements prévisibles, traçables et réplicables, grâce à une automatisation…

-

Automatisation logicielle : pipeline CI/CD et Intégration Continue

L’intégration continue (CI) est une pratique de développement logiciel qui automatise les vérifications à chaque modification du code. Ces vérifications englobent la conformité, la qualité du logiciel et les prérequis pour la mise en production. La CI contribue à réduire la dette technique, facilite le déploiement en assurant le respect des normes définies par les…

-

Architecture de données : vision et défis en 2024

Quel est l’avenir de la l’architecture de données en 2024? Certains experts se sont prononcés sur la question et ont proposé ces tendances sous-mentionnées. Décryptage.

-

le développement logiciel et SDLC : étapes et bonnes pratiques

L’évolution continue du développement logiciel a profondément modifié notre interaction quotidienne avec la technologie. Des applications mobiles aux systèmes d’entreprise complexes, ce processus joue un rôle essentiel dans la création et l’amélioration des solutions technologiques présentes dans notre environnement.

-

IA : 3 tendances à surveiller en 2024

L’avènement de l’IA reste à jamais révolutionnaire et offre une perspective fascinante sur la manière dont elle continuera à remodeler nos vies et nos industries. Plongeons dans ces trois tendances clés qui captiveront le monde de l’IA en 2024.

-

Téléchargez notre livre blanc sur l’usine logicielle devsecops

Explorez le futur du développement logiciel avec notre livre blanc exclusif sur la mise en place d’une Usine Logicielle DevSecOps. Découvrez des stratégies innovantes, des études de cas concrets et des conseils pratiques pour optimiser efficacement votre processus de développement, tout en renforçant la sécurité de vos applications. Téléchargez notre livre blanc dès maintenant pour…

-

DevSecOps : Le pilier incontournable des entreprises

Le passage du DevOps au DevSecOps est crucial pour garantir la sécurité des entreprises. Intégrer la sécurité dès les premières phases de développement et d’exploitation est fondamental pour renforcer la robustesse des systèmes. Cela implique une collaboration étroite, la suppression des cloisonnements entre équipes, l’adoption de mesures préventives telles que la sécurité dès la conception…

-

La technologie verte, tendance en 2024

Vous en entendrez beaucoup parler en 2024 : la technologie verte est une des technologies du futur. Alors que les entreprises cherchent des moyens de minimiser leur impact carbone, la technologie durable émerge comme une solution pour un avenir plus vert.

-

L’observabilité des données, 3 cas d’usage

L’observabilité des données émerge comme une pratique essentielle, offrant des avantages significatifs dans divers secteurs. Examinons de près 3 cas d’usage de l’observabilité des données qui démontrent son importance croissante.

-

Téléchargez notre livre blanc sur la data observability

Découvrez comment la data observability peut améliorer votre data quality à travers notre livre blanc. Les entreprises qui surveillent leurs données augmentent de 70% la probabilité de prendre des décisions basées sur les données fiables. Aussi, elles peuvent réduire de manière significative les incidents liés à ces données jusqu’à 40%. Avec la data observability, vous…

-

data quality management vs data observability : les différences

Data quality management et data observability sont deux termes qui reviennent fréquemment lorsqu’il s’agit de gérer les données au sein d’une entreprise. Comprendre la différence entre ces deux concepts vous permet d’optimiser les processus internes, prendre des décisions éclairées et rester compétitif sur le marché. Explorons ces notions de plus près.

-

3 nouvelles technologies en 2024

Les nouvelles technologies seront influencées par l’évolution rapide de l’IA, la sécurité informatique et la protection de la planète. Nous vous annonçons dans cet article les tendances technologiques en 2024. Tenez-vous prêt !

-

Data lake vs data warehouse : quelle est la différence ?

Data warehouse vs data lake. Deux concepts qui reviennent souvent dans le monde de la gestion des données. Ces deux termes permettent de stocker, gérer et analyser des données. Cependant, leurs fonctionnements diffèrent. Nous vous expliquons la différence entre un data lake et un data warehouse, ainsi que leurs avantages et inconvénients respectifs.

-

business intelligence : Comment optimiser votre stratégie ?

La Business Intelligence (BI) englobe un ensemble de méthodes, de processus et d’outils permettant de collecter, d’analyser et de présenter des données pour aider les entreprises à prendre des décisions éclairées. Dans cet article, nous explorerons en profondeur la Business Intelligence et examinerons les étapes d’une stratégie BI.

-

Data architecture : Comment construire un data lake ?

Un Data Lake s’occupe de la gestion des données au sein d’une entreprise. Mais, mesurez-vous vraiment l’importance qu’il peut avoir dans le management de vos données? Dans cet article, nous allons découvrir ce qu’est un Data Lake, pourquoi il est important, et comment le construire efficacement.

-

Data intelligence : définition, défis et applications

La data intelligence, également connue sous le nom d’intelligence des données, joue un rôle primordial dans la façon dont les organisations collectent, analysent et utilisent les données pour prendre des décisions stratégiques. Dans cet article, nous allons explorer comment elle peut transformer votre entreprise.

-

Data lake vs data lakehouse : décryptage des différences

Les Data Lake et les Data Lakehouses sont des systèmes de stockage et de gestion de données conçus pour gérer la complexité et le volume croissant des données. Cependant, leurs approches diffèrent significativement. Nous vous décryptons les différences dans cet article.

-

Analyse de données : Outils et pratiques

Vous souhaitez prendre des décisions commerciales plus éclairées et plus rentables ? Faites une analyse des données. Autrement dit, adoptez une approche data driven. Dans cet article, nous allons vous expliquer comment exploiter les données analytiques pour le succès de votre entreprise.

-

Data mining : Transformez vos données brutes en données exploitables

Comme nous le savons déjà, les données sont générées à un rythme exponentiel à cette ère numérique. Des transactions en ligne aux interactions sur les médias sociaux, chaque clic laisse une empreinte numérique. Mais à quoi servent toutes ces données brutes si nous ne pouvons pas les exploiter ? C’est là qu’intervient le data mining.

-

Data quality vs data observability : quel est le rapport?

Data quality et data observability sont deux termes qui reviennent souvent dans le monde de l’analyse et de la gestion des données. Bien qu’ils soient liés aux données, ils ont des rôles et des objectifs distincts.

-

Inventiv IT fait l’acquisition du groupe Oyez

Nous avons fait, en juin 2023, l’acquisition du groupe Oyez (ancien membre du groupe Altavia). Oyez est un facilitateur de la transformation digitale des entreprises des secteurs du transport, de l’automobile, du retail, du luxe ou encore de la grande distribution. Ainsi, la structure vient renforcer nos équipes, nos clients et notre expertise digitale. Cela…

-

Comprendre l’observabilité des données

L’observabilité des données entre en jeu dans un monde où les entreprises génèrent et collectent des quantités massives de données. En effet, la simple collecte des données ne suffit plus pour rester compétitif. Les entreprises doivent s’assurer que leurs données sont fiables, exploitables et de haute qualité.

-

ERP cloud : le bon choix à faire

Pourquoi opter pour un ERP sur site ? Voilà une question que vous vous posez certainement. En effet, traditionnellement, les ERP étaient déployés localement, nécessitant des ressources importantes en termes d’infrastructure et de maintenance. Cependant, avec l’avènement de la technologie cloud, de plus en plus d’entreprises se tournent vers l’ERP Cloud, une solution hébergée et…

-

Modelisation des données : 4 meilleures pratiques

La modélisation des données est un concept clé de la gestion des données. Dans cet article, nous allons explorer ce qu’est réellement la modélisation des données, son importance dans le contexte de la gestion des données, ainsi que son rôle essentiel pour assurer une efficacité optimale dans ce domaine.

-

meet-up | green it : quelles actions concrètes pour une transformation digitale à impact positif

Nous avons eu le plaisir de vous accueillir le jeudi 6 avril 2023 à 17h à un meet-up consacré aux chantiers du Green IT. Le replay de notre table ronde est disponible à la demande.

-

cloud : Réduire votre Empreinte Carbone du Numérique

La lutte contre le réchauffement climatique pousse les entreprises à réduire leur empreinte carbone. Elles innovent et s’adaptent rapidement à des systèmes plus verts. Le cloud est un levier de croissance pouvant aussi permettre d’atteindre des ambitions neutres en carbone.

-

Data Governance et Green IT : clés du numérique

Data gouvernance et Green IT sont deux concepts importants. L’augmentation de la quantité de données produites et l’impact environnemental des technologies de l’information est la principale raison de leur fusion. D’une part, la gouvernance des données implique la gestion efficace des données pour garantir leur sécurité et leur fiabilité. Le green IT, de l’autre part,…

-

Data science : tendances et évolutions en 2024

La Data Science connaît une évolution majeure en 2024, marquée par des avancées significatives tant sur le plan technologique que réglementaire.

-

COMMENT FONCTIONNE L’IA Générative ?

Plongeant au cœur de l’évolution de l’intelligence artificielle, nous découvrons un monde en perpétuelle mutation où l’IA générative émerge comme une force créative incontournable. De la naissance de ses modèles fondateurs aux progrès fulgurants des Large Language Models (LLM), chaque avancée façonne un paysage technologique riche en potentiel et en possibilités.

-

Big data : 6 cas d’usage dans la finance

Les cas d’utilisation du big data dans le monde de la finance sont très concrets et dynamiques. Le secteur bancaire est en effet l’un des plus grands producteurs de données, et ce, depuis de nombreuses années. Le mariage des données et de la finance est donc inévitable. Qu’est-ce que cela signifie concrètement ?