En 2026, l’avenir de la data architecture est forgé par plusieurs tendances. Nous vous en avons sélectionné 4 d’entre elles, notamment : la montée en puissance du data mesh, l’essor de l’intelligence artificielle (IA) et de la GenAI (et leur mise en production), la transition vers le cloud et architectures hybrides ainsi que l’évolution des data lakes.

Nous vous décortiquons ces 4 tendances de la data architecture :

1. L’émergence du data mesh

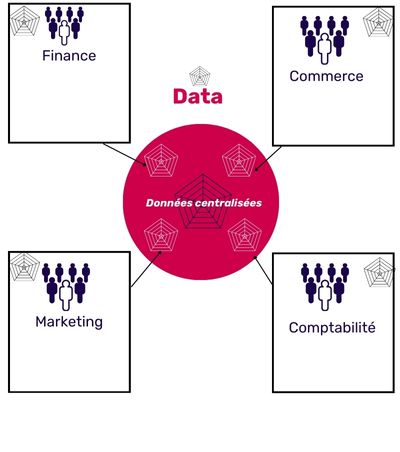

Le maillage de données marque une révolution dans la façon dont les entreprises conçoivent leur architecture de données. En effet, le data mesh vise à décentraliser la gestion des données et à responsabiliser les différentes équipes au sein de l’organisation.

Traditionnellement, les données étaient souvent centralisées. Cependant, le data mesh propose une approche différente, en encourageant la distribution des responsabilités liées aux données à travers l’ensemble de l’organisation. Autrement dit, chaque équipe ou domaine fonctionnel est responsable de la gestion de ses propres données, favorisant ainsi une meilleure autonomie et une prise de décision plus rapide, une méthodologie qui pourrait s’inspirer du succès observé dans ces secteurs.

En 2026, on observe toutefois une approche plus “pragmatique” : l’idée de donnée comme produit (data product) se consolide, avec des attentes plus concrètes (qualité mesurée, documentation, SLA, règles d’accès), souvent supportées par une plateforme data qui fournit standards, sécurité et observabilité.

Les défis?

Les entreprises peuvent surmonter les défis liés aux silos de données, favoriser une culture de la responsabilité et de l’autonomie, et améliorer la qualité globale de leurs données. Par conséquent, il est important de noter que la transition vers un modèle de data mesh peut nécessiter des ajustements culturels, organisationnels et technologiques.

« Les Data Analysts ne devraient pas adopter la data mesh architecture comme une solution apparemment simple à leurs défis de gestion des données. Bien qu’il formalise des pratiques communes, il abdique la responsabilité des données au profit des experts métiers, ce qui risque de multiplier les utilisations cloisonnées des données. »

Gartner.

Téléchargez le livre blanc sur la data observability

2. La montée en puissance de l’IA

L’intelligence artificielle, particulièrement la GenAI ne cesse d’innover dans le monde de la data. Traditionnellement considérées comme une ressource statique, les données deviennent désormais dynamiques et évolutives grâce à l’influence croissante de l’IA.

D’abord, la Generative AI exploite les données de manière intelligente, facilitant la création de modèles plus précis et performants. Cette symbiose entre l’IA et les données entraîne une amélioration continue des algorithmes, conduisant à des analyses plus fines et à des prédictions plus fiables.

Aussi, un aspect remarquable de l’impact de l’IA dans l’architecture des données est la génération automatique de code SQL, de tags, et de documentation détaillée. En effet, l’IA générative, combinée aux modèles de langage avancés, excelle dans la création automatisée de requêtes SQL optimisées, simplifiant ainsi le processus de manipulation des données.

De plus, la génération automatique de tags et de documentation apporte une clarté qui facilite la compréhension et la gestion des ensembles de données complexes.

Enfin, l’IA contribue à rendre les solutions de données plus adaptables et réactives. Les systèmes sont capables d’apprendre des schémas de données changeants, s’ajustant en temps réel aux évolutions du contexte commercial. La conséquence est ainsi, une flexibilité accrue dans la gestion des données, répondant efficacement aux besoins fluctuants des entreprises.

En 2026, cette dynamique se renforce avec des usages plus opérationnels, notamment :

- l’exploitation de données non structurées (documents, tickets, contenus) via des approches de recherche sémantique / RAG ;

- des assistants et agents capables d’enchaîner des actions (requêtage, synthèse, recommandation), ce qui impose de meilleurs garde-fous ;

- une exigence accrue de “données prêtes pour l’IA” : qualité, fraîcheur, traçabilité (lineage), règles d’accès et contexte métier.

Les défis?

Cependant, cet impact positif n’est pas sans défis. Le challenge le plus évident est la sécurisation des données. En effet, l’IA manipule des quantités massives d’informations sensibles. Les data architectes devraient ainsi travailler en étroite collaboration avec les experts en sécurité pour garantir une protection adéquate.

En 2026, s’ajoutent aussi des enjeux de fiabilité et de gouvernance : limiter les erreurs, contrôler les accès, tracer les sources utilisées, et encadrer les usages (notamment quand l’IA est connectée à des données internes).

3. La transition vers le cloud et architectures hybrides

La consolidation des architectures hybrides est l’une des tendances capitales observées. Cette approche, combinant les infrastructures locales et le cloud, s’est avérée être la solution idéale pour concilier flexibilité opérationnelle et conformité aux contraintes règlementaires et financières. Les entreprises adoptent massivement cette approche afin de tirer parti des avantages du cloud computing tout en préservant le contrôle sur certaines données sensibles stockées localement.

Parallèlement, la montée en puissance des solutions multicloud a profondément transformé la manière dont les organisations abordent le stockage et le traitement des données. Cette tendance résulte de la volonté de diversifier les fournisseurs cloud, minimisant ainsi les risques liés à une dépendance excessive envers un unique prestataire.

En 2026, ces choix sont de plus en plus influencés par :

- la résilience (continuité d’activité, dépendances critiques) ;

- la souveraineté et la localisation de certaines données ;

- la maîtrise des coûts (généralisation des approches FinOps et de l’optimisation du compute).

Les défis?

Toutefois, la migration vers le cloud soulève des préoccupations éthiques importantes, notamment en ce qui concerne la confidentialité et la sécurité des données. Les entreprises sont confrontées au défi de garantir une protection adéquate tout en exploitant les avantages du cloud en termes de scalabilité et d’accessibilité.

4. L’évolution des data lakes et concurrence entre les formats de table

Malgré le déclin d’Hadoop, les data lakes demeurent indispensables en 2024 pour garantir la flexibilité et la mise à l’échelle des données. Cette évolution est notamment marquée par l’émergence d’alternatives à Hadoop, telles que les data lakes sur site basés sur le stockage d’objets.

Parallèlement, on observe une compétition dans le domaine des formats de table. Des acteurs tels qu’Apache Iceberg, Delta Lake et Hudi rivalisent pour devenir le standard du secteur. Cette compétition exerce une influence significative, stimulant l’innovation et poussant les acteurs du marché à améliorer constamment leurs offres.

En 2026, on observe aussi une consolidation des approches de type lakehouse, avec davantage d’attention portée à :

- la gouvernance et la gestion des métadonnées (catalogue, traçabilité, règles d’accès) ;

- l’interopérabilité entre plusieurs moteurs et usages (BI, data science, streaming) ;

- l’optimisation des performances et des coûts (stockage, compute, requêtes).

Quel défi majeur ?

Même si les data lakes offrent une flexibilité accrue, le coût associé au stockage et à l’accès à d’énormes volumes de données peut devenir prohibitif. Optimiser l’efficacité tout en gérant les coûts devient donc l’un des défis stratégiques.

Ce qu’il faut retenir :

L’évolution rapide de l’architecture des données en 2026 offre des avantages significatifs tels que le potentiel du data mesh, l’efficacité accrue grâce à l’IA, et la flexibilité des architectures hybrides. Cependant, ces progrès s’accompagnent de défis tels que : la sécurisation des données, la gouvernance des usages IA, la maîtrise des coûts, et le risque d’utilisations cloisonnées des données.

La réussite future réside dans la capacité à surmonter ces obstacles, tout en maintenant une agilité et une robustesse adaptées aux demandes dynamiques de l’environnement informatique actuel.